HOME>Global Tech >Trend

AI 시대의 핵심 인프라,

하이퍼스케일 데이터센터

하이퍼스케일 데이터센터

정보통신 기술이 시대를 바꾸는 힘이라면, 데이터는 그 힘을 뒷받침하는 연료다. 데이터라는 연료가 끊임없이 흐르는 디지털 시대의 한복판에 이곳이 존재한다. 빅데이터에 기반한 클라우드 서비스도, 최근 인기 높은 생성 AI도 이곳이 없으면 존재할 수 없다. 최소 10만 대의 서버를 수용할 수 있는 초대형 데이터센터, 인공지능 시대 핵심 인프라, 하이퍼스케일 데이터센터다.

데이터센터가 멈추면 세상이 멈춘다

지난 2021년 3월, 프랑스 동부 스트라스부르에 있는 OVH 데이터센터에서 화재가 발생했다. 5층 규모 데이터센터 4개 동 중 1개 동을 모두 불태운 이 화재로, 프랑스 정부 및 현대 미술관

퐁피두센터, 게임 러스트의 유럽 서버, 암호화폐거래소 코인하우스 등 1만6000여 개의 기업이 피해를 보았다. 2022년 10월 발생한 SK C&C 데이터센터 화재 사건을 기억하는 사람도 많다.

카카오톡을 비롯해 관련 서비스를 아예 쓸 수 없었던, 거의 모든 국민이 불편함을 겪은 당혹스러운 사건이었다. 사업 목적으로 카카오 서비스를 활용했던 가게까지 타격을 입었다. 데이터센터가 우리 사회에

얼마나 중요한 존재인지를 확실히 알게 된 때다.

1990년대 처음 인터넷 붐이 일 때만 해도, 세상이 이 정도로 바뀌리라 생각하진 않았다. 데이터센터란 무엇인가? 그저 수많은 컴퓨터와 네트워크 장비, 저장장치가 들어가 있는 시설이다. 수많은 웹서비스가 이 시설을 기반으로 운영되지만, 웹서비스 불통이 단전이나 단수와 같은 취급을 받게 될 거라고 누가 상상이나 했을까.

처음부터 이랬던 것은 아니다. 컴퓨터 룸이라고 불린 초기 데이터센터는, 그때 만들어진 컴퓨터가 엄청나게 컸기 때문에 어쩔 수 없이 태어났다. 예를 들어 최초의 컴퓨터 중 하나인 에니악ENIAC 같은 경우 무게만 30톤, 크기는 30×1×2m, 소비 전력은 150kW에 달했기에, 따로 공간을 만들어 관리해야 했다. 이후 컴퓨터가 책장 크기의 미니컴퓨터, 가방 크기의 마이크로컴퓨터PC로 작아지면서 사무실이나 건물 일부에 들어간 컴퓨터실은, 1990년대 후반 인터넷 시대에 접어들면서 변화를 맞이하게 된다. 점점 관리해야 할 컴퓨터가 많아지면서 일반 사무실에 놓고 쓰는 게 어려워졌고, 컴퓨터만 설치할 수 있는 건물을 지어 빌려주기 시작했다. 지금 생각하는 데이터센터가 이때 태어났다.

1998년, 구글이 처음 데이터센터에 입주했을 때 설치한 PC는 몇 대였을까? 고작 30대다. 구글이 검색의 대명사가 된 2016년에는 30대의 컴퓨터가 약 250만 대로 늘어났다. 이 많은 컴퓨터를 수용하려면 어쩔 수 없이 데이터센터도 커져야 한다. 하이퍼스케일 데이터센터는 그래서 태어났다. 말 그대로 초거대 센터를 의미한다.

전에는 서버 5000대 정도를 수용할 수 있는 곳을 가리키다가, 요즘엔 축구장 3개 정도 되는 총면적 2만2500㎡ 정도 크기에 서버 10만 대 이상, 전력량 20MW 이상을 지원하는 데이터센터를 지칭한다. 보통 MS나 아마존, 구글 같은 대형 클라우드 사업자들이 운영하는 곳이 여기에 해당한다.

1990년대 처음 인터넷 붐이 일 때만 해도, 세상이 이 정도로 바뀌리라 생각하진 않았다. 데이터센터란 무엇인가? 그저 수많은 컴퓨터와 네트워크 장비, 저장장치가 들어가 있는 시설이다. 수많은 웹서비스가 이 시설을 기반으로 운영되지만, 웹서비스 불통이 단전이나 단수와 같은 취급을 받게 될 거라고 누가 상상이나 했을까.

처음부터 이랬던 것은 아니다. 컴퓨터 룸이라고 불린 초기 데이터센터는, 그때 만들어진 컴퓨터가 엄청나게 컸기 때문에 어쩔 수 없이 태어났다. 예를 들어 최초의 컴퓨터 중 하나인 에니악ENIAC 같은 경우 무게만 30톤, 크기는 30×1×2m, 소비 전력은 150kW에 달했기에, 따로 공간을 만들어 관리해야 했다. 이후 컴퓨터가 책장 크기의 미니컴퓨터, 가방 크기의 마이크로컴퓨터PC로 작아지면서 사무실이나 건물 일부에 들어간 컴퓨터실은, 1990년대 후반 인터넷 시대에 접어들면서 변화를 맞이하게 된다. 점점 관리해야 할 컴퓨터가 많아지면서 일반 사무실에 놓고 쓰는 게 어려워졌고, 컴퓨터만 설치할 수 있는 건물을 지어 빌려주기 시작했다. 지금 생각하는 데이터센터가 이때 태어났다.

1998년, 구글이 처음 데이터센터에 입주했을 때 설치한 PC는 몇 대였을까? 고작 30대다. 구글이 검색의 대명사가 된 2016년에는 30대의 컴퓨터가 약 250만 대로 늘어났다. 이 많은 컴퓨터를 수용하려면 어쩔 수 없이 데이터센터도 커져야 한다. 하이퍼스케일 데이터센터는 그래서 태어났다. 말 그대로 초거대 센터를 의미한다.

전에는 서버 5000대 정도를 수용할 수 있는 곳을 가리키다가, 요즘엔 축구장 3개 정도 되는 총면적 2만2500㎡ 정도 크기에 서버 10만 대 이상, 전력량 20MW 이상을 지원하는 데이터센터를 지칭한다. 보통 MS나 아마존, 구글 같은 대형 클라우드 사업자들이 운영하는 곳이 여기에 해당한다.

지난 2022년 10월에 발생한 경기 성남시 분당구 SK C&C 판교캠퍼스 카카오 데이터센터 화재로 인해 카카오톡을 비롯한 관련 서비스

모두가 일시 정지되었다. 사진은 화재 현장 감식을 위해 소방·경찰 관계자들이 센터 내부로 이동하고 있는 모습

일반 센터와 하이퍼스케일 센터의 기술 차이

하이퍼스케일은 확장성이 좋다. 최근 주목받는 생성형 AI처럼 갑자기 엄청나게 많은 컴퓨터 자원이 필요한 상황이 와도 대처할 수 있다. 하이퍼스케일 데이터센터는 레고처럼 서버 컴퓨터를 추가할 수 있는

모듈식으로 시스템을 구성하기 때문에 이런 수요 변화에 맞춰 확장할 수 있다.

자동화 역시 일반 센터보다 하이퍼스케일 데이터센터가 더 잘하는 분야다. 소프트웨어는 최신 상태를 유지해야 한다. 이런 업데이트를 일일이 사람이 한다면 수십만 대의 컴퓨터를 관리할 수 없다. 따라서 자동화 프로그램을 통해 해결한다. 자동 복구 기능을 갖춘 모니터링 프로그램도 있다.

더 뛰어난 냉각 시스템도 갖추고 있다. 컴퓨터 시스템은 더 많은 전력을 쓸수록 더 많은 열을 발산하는데, 식혀주지 않으면 고장이 나기 쉽다. 효과적으로 열을 내리기 위해, 액체가 담겨 있는 부품을 컴퓨터 부품에 직접 닿게 하는 수랭식 냉각 시스템을 주로 쓴다. 아예 컴퓨터를 액체에 담가 냉각하는 액침 냉각 방식도 도입될 예정이다.

그 밖에도 다른 최신 기술이 모두 녹아 들어 있다. 빠르고 안정적으로 많은 데이터를 처리하기 위해 소프트웨어 정의 네트워킹SDN, Software Defined Network이나 고속 상호 연결 같은 고급 네트워킹 기술 등도 지원한다.

자동화가 잘된 시스템에 뛰어난 전기 관리 능력, 냉각 능력 등을 합치니 일반 데이터센터보다 에너지도 더 아껴 쓴다. 중요한 데이터 처리 시설이니 강한 온·오프라인 보안 시스템도 갖추고 있다. 서로 다른 지역에 있는 데이터센터에 자료를 백업하고, 장애가 발생하면 백업 시스템으로 연결해 서비스 중단 없이, 안전하게 복구할 수도 있다.

자동화 역시 일반 센터보다 하이퍼스케일 데이터센터가 더 잘하는 분야다. 소프트웨어는 최신 상태를 유지해야 한다. 이런 업데이트를 일일이 사람이 한다면 수십만 대의 컴퓨터를 관리할 수 없다. 따라서 자동화 프로그램을 통해 해결한다. 자동 복구 기능을 갖춘 모니터링 프로그램도 있다.

더 뛰어난 냉각 시스템도 갖추고 있다. 컴퓨터 시스템은 더 많은 전력을 쓸수록 더 많은 열을 발산하는데, 식혀주지 않으면 고장이 나기 쉽다. 효과적으로 열을 내리기 위해, 액체가 담겨 있는 부품을 컴퓨터 부품에 직접 닿게 하는 수랭식 냉각 시스템을 주로 쓴다. 아예 컴퓨터를 액체에 담가 냉각하는 액침 냉각 방식도 도입될 예정이다.

그 밖에도 다른 최신 기술이 모두 녹아 들어 있다. 빠르고 안정적으로 많은 데이터를 처리하기 위해 소프트웨어 정의 네트워킹SDN, Software Defined Network이나 고속 상호 연결 같은 고급 네트워킹 기술 등도 지원한다.

자동화가 잘된 시스템에 뛰어난 전기 관리 능력, 냉각 능력 등을 합치니 일반 데이터센터보다 에너지도 더 아껴 쓴다. 중요한 데이터 처리 시설이니 강한 온·오프라인 보안 시스템도 갖추고 있다. 서로 다른 지역에 있는 데이터센터에 자료를 백업하고, 장애가 발생하면 백업 시스템으로 연결해 서비스 중단 없이, 안전하게 복구할 수도 있다.

하이퍼스케일 데이터센터를 계속 짓는 이유

인터넷 산업을 지탱하는 하이퍼스케일 데이터센터, 그렇지만 만드는 것은 쉽지 않다. 자연재해, 전기 공급 등 장소를 고를 때 따져야 할 요소도 많고, 법적 규제를 받거나 지역사회의 반대에 부딪히기도

한다. 그런데도 하이퍼스케일 데이터센터가 늘어나는 건, 세상이 점점 더 많은 데이터를 처리할 수 있는 컴퓨터 시스템을 요구해서다.

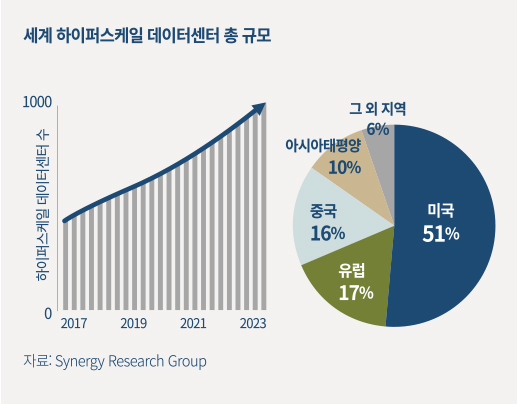

실제로 미국의 시장 조사 기업, 시너지 리서치 그룹Synergy Research Group에서 발표한 보고서를 보면, 하이퍼스케일 데이터센터는 2023년 말 1000개를 돌파했다. 2018년 말 기준으로 430여 개가 있었으니, 지난 5년 사이에 500개가 넘는 하이퍼스케일 데이터센터가 건설됐다는 말이다.

이런 흐름을 이끈 것은 코로나19다. 비대면 생활 환경이 중요해지면서 인터넷 수요가 폭증했다. 보통은 이렇게 확 늘었다가 잠잠해지는 편인데, 이번엔 수요가 줄지 않고 계속 늘었다. 생성형 AI 때문이다. 생성형 AI는 훈련과 사용에 초대형 데이터를 이용하기에, 어마어마한 컴퓨터 자원이 필요하다.

예를 들어 챗GPT3의 경우, 원본 학습 데이터 크기는 45TB에 달한다. 챗GPT3를 사용할 때 AI가 대답에 이용하는 파라미터의 수만 약 1750억 개다. 이를 가동하는 컴퓨터 시스템은 엔비디아의 HGX A100 서버 3600여 대다. 총 2만8900여 개의 GPU를 쓰고 있으며, 하루 사용료가 약 70만 달러(한화 약 9억6000만 원)에 달한다고 알려졌다.

실제로 미국의 시장 조사 기업, 시너지 리서치 그룹Synergy Research Group에서 발표한 보고서를 보면, 하이퍼스케일 데이터센터는 2023년 말 1000개를 돌파했다. 2018년 말 기준으로 430여 개가 있었으니, 지난 5년 사이에 500개가 넘는 하이퍼스케일 데이터센터가 건설됐다는 말이다.

이런 흐름을 이끈 것은 코로나19다. 비대면 생활 환경이 중요해지면서 인터넷 수요가 폭증했다. 보통은 이렇게 확 늘었다가 잠잠해지는 편인데, 이번엔 수요가 줄지 않고 계속 늘었다. 생성형 AI 때문이다. 생성형 AI는 훈련과 사용에 초대형 데이터를 이용하기에, 어마어마한 컴퓨터 자원이 필요하다.

예를 들어 챗GPT3의 경우, 원본 학습 데이터 크기는 45TB에 달한다. 챗GPT3를 사용할 때 AI가 대답에 이용하는 파라미터의 수만 약 1750억 개다. 이를 가동하는 컴퓨터 시스템은 엔비디아의 HGX A100 서버 3600여 대다. 총 2만8900여 개의 GPU를 쓰고 있으며, 하루 사용료가 약 70만 달러(한화 약 9억6000만 원)에 달한다고 알려졌다.

하이퍼스케일 데이터센터의 미래와 고민거리

시너지 리서치 그룹은 앞으로 4년 안에 하이퍼스케일 데이터센터가 2배로 늘 거라고 예상했다. 실제로 올해 들어 메타에서는 미국에 8억 달러짜리 데이터센터 3개를 짓는다고 했다. 구글은

신규

데이터센터에 20억 달러, 데이터센터 확장에 10억 달러를 쓴다고 발표했다. MS는 독일과 일본, 스페인에 각각 34억, 29억, 21억 달러를 들여 데이터센터를 지을 예정이다. 아마존은

올해 100억 달러, 향후 15년간 1500억 달러 투자 계획이 있다는 보도도 있었다.

문제는 다시 에너지와 인공지능이다. 글로벌 컨설팅업체 맥켄지Mckinsey에 따르면, 미국 데이터센터의 전력 소비량은 2022년 17GW에서 2030년 35GW로 증가할 것으로 예상했다. 한국 표준형 원전 용량이 1GW니, 원전 17기에서 35기가 최대로 생산할 수 있는 전기를 쓰는 셈이다. 이 가운데 하이퍼스케일 데이터센터가 차지하는 비중은 약 20%이며, 점점 더 커질 전망이다.

국제에너지기구IEA에서 추산한 데이터센터 전력 소비량은 최대 340TWh다(2022년 기준). 많은 개선이 있었지만, 그래도 세계 전략 수요의 1~1.3%를 차지한다고 했다. 앞으로 AI에 관한 연구가 계속되고, 그에 따라 하이퍼스케일 데이터센터가 늘어나면 전력 소비량도 늘 수밖에 없다. 테슬라 CEO 일론 머스크가 2025년이 되면 전기가 부족할 것이라 말했던 이유다.

문제는 다시 에너지와 인공지능이다. 글로벌 컨설팅업체 맥켄지Mckinsey에 따르면, 미국 데이터센터의 전력 소비량은 2022년 17GW에서 2030년 35GW로 증가할 것으로 예상했다. 한국 표준형 원전 용량이 1GW니, 원전 17기에서 35기가 최대로 생산할 수 있는 전기를 쓰는 셈이다. 이 가운데 하이퍼스케일 데이터센터가 차지하는 비중은 약 20%이며, 점점 더 커질 전망이다.

국제에너지기구IEA에서 추산한 데이터센터 전력 소비량은 최대 340TWh다(2022년 기준). 많은 개선이 있었지만, 그래도 세계 전략 수요의 1~1.3%를 차지한다고 했다. 앞으로 AI에 관한 연구가 계속되고, 그에 따라 하이퍼스케일 데이터센터가 늘어나면 전력 소비량도 늘 수밖에 없다. 테슬라 CEO 일론 머스크가 2025년이 되면 전기가 부족할 것이라 말했던 이유다.

기후위기로 인해 세계가 재생에너지 전환을 촉구하는 시점에서, 하이퍼스케일 데이터센터는 엄청나게 많은 전기를 요구한다. 덕분에 미국 일부 지역에선 이미 전기료가 올라가기

시작했다. 이 문제를 해결하기 위해 많은 궁리를 하고 있지만, 결코 풀기 쉬운 문제가 아니다. 과연 인류는 어떤 선택을 하게 될까?

이요훈 IT 칼럼니스트

전 아리랑TV 비즈테크코리아 MC, 한양대 미래인문학융합학부 IAB 자문교수, 한국과학기술평가원KISTEP 전문위원이었으며, 현재 IT 칼럼니스트로 활동하고 있다.

이번 호 PDF 다운로드

이번 호 PDF 다운로드