HOME>Focus Story> Issue

인공지능 시대의 반도체

GPU와 HBM, 단순함이 만들어낸 복잡함

GPU와 HBM, 단순함이 만들어낸 복잡함

2022년 말, 챗GPT가 출시되자 전 세계 IT산업은 흥분의 도가니에 빠졌다. 이 분위기는 반도체 시장으로도 빠르게 퍼졌다. 처음에는 인공지능AI 필수 반도체인 GPU를 만드는 엔비디아NVIDIA에게 수혜가 쏟아졌고 이후 한국으로 이어졌다. 엔비디아가 필요로 하는 고대역폭 메모리HBM, High-Bandwidth Memory는 한국 기업들이 생산하는 제품이었기 때문이다. 반도체 불황이라는 뉴스는 1년 만에 사라졌고, 지난 수십 년 반도체 일인자 자리를 지켜왔던 인텔Intel의 이름도 듣기 힘들게 되었다. 대체 무슨 일이 일어난 것일까?

반도체에 대해 제대로 알아야 하는 이유

우리는 반도체를 ‘현대사회의 핵심부품’, ‘21세기 석유’ 등으로 비유했다. 이는 반도체의 중요성을 설명하는 데는 적절하지만 지금처럼 기술적 혁신이 일어났을 때 각 반도체의 위상이 어떻게 바뀌는지를

알기는 어렵다. AI 혁명으로 반도체가 매우 중요하다는 것은 독자분들도 알고 있을 것이다.하지만 인텔의 CPU에서 엔비디아의 GPU로 핵심 반도체가 달라진 이유를 알고 있는가? 이를 모르고 그냥

넘어간다면, 다음 혁신을 놓치게 될지도 모른다.

사실 우리가 원하는 것은 반도체가 아니다. 컴퓨터 프로그램이다. 컴퓨터 프로그램은 우리 삶을 풍요롭게 만들었다. 마이크로소프트Microsoft의 엑셀은 수백만 개의 거래 내역이 담긴 회계장부를 몇 초 만에 계산할 수 있게 해주었고, 스마트폰의 지도 앱은 어디에 있어도 내 위치를 정확히 파악하고 최선의 경로를 선택할 수 있게 해주었다. 이는 과거 무한한 권력을 누리던 황제들도 경험하지 못한 혁신이다. 챗GPT와 같은 대화형 AI 역시 같은 맥락이다. 과거에는 안 되던 것이 AI라는 새로운 프로그램에 의해 가능해지고 있다. 만약 AI가 다른 방식으로 운영된다면, 반도체는 없어도 상관없을 것이다.

사실 우리가 원하는 것은 반도체가 아니다. 컴퓨터 프로그램이다. 컴퓨터 프로그램은 우리 삶을 풍요롭게 만들었다. 마이크로소프트Microsoft의 엑셀은 수백만 개의 거래 내역이 담긴 회계장부를 몇 초 만에 계산할 수 있게 해주었고, 스마트폰의 지도 앱은 어디에 있어도 내 위치를 정확히 파악하고 최선의 경로를 선택할 수 있게 해주었다. 이는 과거 무한한 권력을 누리던 황제들도 경험하지 못한 혁신이다. 챗GPT와 같은 대화형 AI 역시 같은 맥락이다. 과거에는 안 되던 것이 AI라는 새로운 프로그램에 의해 가능해지고 있다. 만약 AI가 다른 방식으로 운영된다면, 반도체는 없어도 상관없을 것이다.

컴퓨터와 반도체의 관계

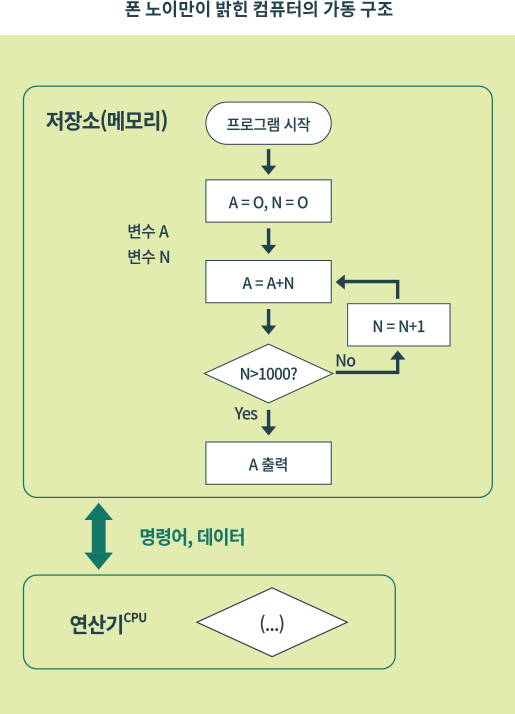

이제 알아봐야 할 것은 프로그램과 반도체와의 관계이다. 이를 설명하기 전, 컴퓨터의 구조를 간단히 알 필요가 있다. 컴퓨터 학자들은 컴퓨터가 ‘저장소’와 ‘연산기’로 구성되어야 한다고 생각했다.

저장소에 우리가 원하는 프로그램과 프로그램 수행 시 참고해야 할 데이터를 저장하고, 연산기가 프로그램과 참고 데이터를 읽어오는 방식으로 구성해야 한다는 것이다. 예를 들어 필자가 이 원고를 쓸 때

사용한 워드 프로그램으로 설명해보겠다. 워드 프로그램 자체와 문서에 사용한 이미지 등은 저장소에 존재한다. 이때 필자가 프로그램을 실행하고 해당 이미지를 불러온다. 그러면 연산기가 프로그램의 일부와

이미지를 저장소에서 가져와 작업을 수행하는 것이다.

컴퓨터 제조사들은 반도체로 만들어진 연산기와 메모리를 도입하였다. 반도체 기술을 사용하면 2년마다 2배씩 연산기와 저장소의 성능을 높일 수 있으니 더욱 빠른 컴퓨터를 만들 수 있기 때문이다. 가끔 뉴스에서 보이는 CPU와 GPU가 반도체로 만들어진 대표적 연산기이고, 메모리가 바로 반도체 기술로 만든 저장소이다. 컴퓨터가 계속 발전하며 더 최신의 반도체를 사용하고 다른 장치들이 추가되었지만, 이 기본적인 구조는 지금까지도 계속 유지되고 있다.

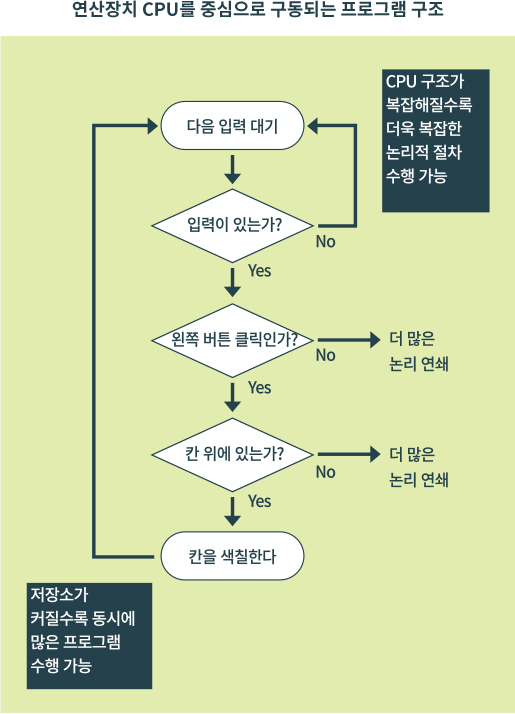

반도체 기업들은 매해 더 나은 반도체를 개발하며 컴퓨터 프로그램의 구동 속도를 높였다. 초기 프로그램은 엑셀, 워드 등의 사무 프로그램으로 논리적 절차가 복잡하기는 하나, 별도의 결함만 없다면 인간이 따라갈 수 없는 정확도와 빠른 속도로 다량의 작업을 수행했다. 당시 연산기의 최강자는 인텔이었다. 인텔은 IBM에 CPU라는 연산 반도체를 공급하며 세계 최고의 반도체 회사로 성장했다. 인텔은 반도체 기술을 이용해, 복잡한 논리 연쇄를 더 빠르게 수행할 수 있는 CPU를 지속적으로 개발하였다. 이때 삼성전자와 SK하이닉스 등 국내 메모리 반도체 기업들은 프로그램 요구에 맞춰 단순하지만 값싸고 용량이 큰 메모리를 제조했다.

컴퓨터 제조사들은 반도체로 만들어진 연산기와 메모리를 도입하였다. 반도체 기술을 사용하면 2년마다 2배씩 연산기와 저장소의 성능을 높일 수 있으니 더욱 빠른 컴퓨터를 만들 수 있기 때문이다. 가끔 뉴스에서 보이는 CPU와 GPU가 반도체로 만들어진 대표적 연산기이고, 메모리가 바로 반도체 기술로 만든 저장소이다. 컴퓨터가 계속 발전하며 더 최신의 반도체를 사용하고 다른 장치들이 추가되었지만, 이 기본적인 구조는 지금까지도 계속 유지되고 있다.

반도체 기업들은 매해 더 나은 반도체를 개발하며 컴퓨터 프로그램의 구동 속도를 높였다. 초기 프로그램은 엑셀, 워드 등의 사무 프로그램으로 논리적 절차가 복잡하기는 하나, 별도의 결함만 없다면 인간이 따라갈 수 없는 정확도와 빠른 속도로 다량의 작업을 수행했다. 당시 연산기의 최강자는 인텔이었다. 인텔은 IBM에 CPU라는 연산 반도체를 공급하며 세계 최고의 반도체 회사로 성장했다. 인텔은 반도체 기술을 이용해, 복잡한 논리 연쇄를 더 빠르게 수행할 수 있는 CPU를 지속적으로 개발하였다. 이때 삼성전자와 SK하이닉스 등 국내 메모리 반도체 기업들은 프로그램 요구에 맞춰 단순하지만 값싸고 용량이 큰 메모리를 제조했다.

수학자이자 물리학자인 폰 노이만을 중심으로 한 연구팀이 1945년에 제안한

구조. 최초로 CPU와 메모리, 프로그램 구조를 설명했다.

구조. 최초로 CPU와 메모리, 프로그램 구조를 설명했다.

ㅤㅤ

ㅤ

ㅤ

인공지능과 GPU

미국 캘리포니아 엔비디아 본사. AI 칩 인기와 함께 MS와 애플을 제치고

시가총액 1위에 오르는 등 2024년 가장 주목받는 기업이 되었다.

시가총액 1위에 오르는 등 2024년 가장 주목받는 기업이 되었다.

하지만 위와 같은 순서도 구조의 프로그램으로 할 수 없는 일들도 존재했다. 사람의 얼굴이나 사물 등을 구별하는 일이 대표적이다. 인간은 ‘척 보면 딱’ 하고 사람이나 사물을 구분한다. 이를

논리적으로 설명하기는 어렵다. 따라서 기존 컴퓨터 프로그램으로는 이런 일을 해낼 수가 없다. CPU가 아무리 복잡하고 빨라진들, 만드는 방법 자체를 모르니 말이다. 그리고 1960년대

‘인간의 뇌세포 구조’에서 아이디어를 차용한 연구자들이 나타났다. AI 분야에서 ‘인공신경망’을 연구한 사람들이다.

인간의 뇌는 복잡하지만, 뇌를 구성하는 뇌세포들은 단순하다. 입력 신호가 있고, 입력값이 특정 수준을 넘으면 연결되어 있는 다른 뇌세포에게 신호를 전달한다. 이런 단순 구조를 층층이 쌓으면 지능이 발현되는 것이다. 하지만 개념과 달리 실제 연구에는 속도가 나지 않았다. 프로그램 자체를 뇌세포와 비슷하게 만들 수는 있었지만, 정답을 말하게 하려면(=학습) 인공 뇌세포를 어떻게 연결하고 조절해야 하는지 몰랐기 때문이다. 또 당시 반도체 기술로는 수억 개는 고사하고 수만 개 수준의 인공 뉴런도 구동시키기 힘들었다. 기존에 사용하던 연산기 CPU는 복잡하고 논리적 처리는 잘했지만, 대규모의 연산을 단순 반복 처리하는 데 적합한 칩은 아니었기 때문이다. 위 두 문제 중 학습 방법 문제는 1987년 제프리 힌턴 박사에 의해 해결되었고, 연산 능력 문제는 2007년 GPU가 인공지능에 적극적으로 사용되기 시작하며 해결되었다.

인간의 뇌는 복잡하지만, 뇌를 구성하는 뇌세포들은 단순하다. 입력 신호가 있고, 입력값이 특정 수준을 넘으면 연결되어 있는 다른 뇌세포에게 신호를 전달한다. 이런 단순 구조를 층층이 쌓으면 지능이 발현되는 것이다. 하지만 개념과 달리 실제 연구에는 속도가 나지 않았다. 프로그램 자체를 뇌세포와 비슷하게 만들 수는 있었지만, 정답을 말하게 하려면(=학습) 인공 뇌세포를 어떻게 연결하고 조절해야 하는지 몰랐기 때문이다. 또 당시 반도체 기술로는 수억 개는 고사하고 수만 개 수준의 인공 뉴런도 구동시키기 힘들었다. 기존에 사용하던 연산기 CPU는 복잡하고 논리적 처리는 잘했지만, 대규모의 연산을 단순 반복 처리하는 데 적합한 칩은 아니었기 때문이다. 위 두 문제 중 학습 방법 문제는 1987년 제프리 힌턴 박사에 의해 해결되었고, 연산 능력 문제는 2007년 GPU가 인공지능에 적극적으로 사용되기 시작하며 해결되었다.

GPU는 Graphic Processing Unit의 약자로, 당초 그래픽을 처리하기 위해 개발된 반도체였다. 1980년대 사람들은 컴퓨터의 잠재력을 알게 되었고, 그래픽 작업 역시 컴퓨터로

처리하려는

욕구가 높아졌다. 하지만 CPU로는 그래픽을 처리하기가 어려웠다. 이에 따라 그래픽만을 전문적으로 처리하기 위한 새로운 반도체 ‘VGA(GPU)’가 등장하게 된 것이다. 이후 CPU와 GPU가 각각

프로그램과 그래픽을 나눠 처리하는 분업이 시작됐다.

GPU 시장에도 경쟁이 일어났고, 결국 NVIDIA가 GPU 시장을 장악하게 된다. 시장을 장악한 NVIDIA는 GPU로 그래픽 이외의 작업도 할 수 있게 하기 위해 다양한 지원을 하였고, 이 덕분에 캐나다의 AI 연구원들이 GPU를 사용해볼 수 있게 되었다.

GPU 시장에도 경쟁이 일어났고, 결국 NVIDIA가 GPU 시장을 장악하게 된다. 시장을 장악한 NVIDIA는 GPU로 그래픽 이외의 작업도 할 수 있게 하기 위해 다양한 지원을 하였고, 이 덕분에 캐나다의 AI 연구원들이 GPU를 사용해볼 수 있게 되었다.

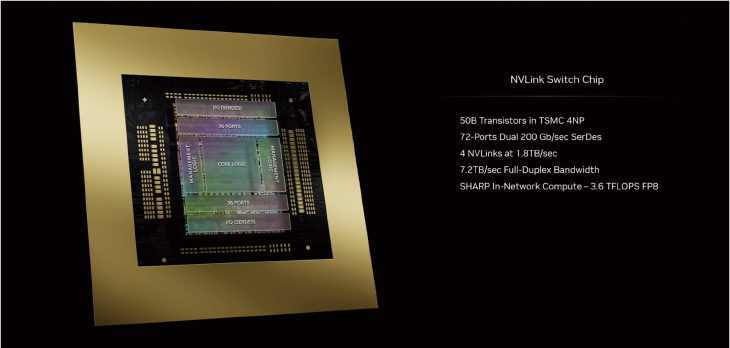

지난 3월 엔비디아의 CEO 젠슨 황이 발표한 NVLink Switch.

최대 576개의 완전히 연결된 GPU를 지원할 수 있는 최초의 랙 수준 스위치 칩이다.

미국 반도체 기업 AMD는 지난 2023년 6월, AI 학습에 필수적인 반도체 그래픽처리장치GPU 신모델을 공개하며 엔비디아에 도전장을 내밀었다.

사진 속 인물은 리사 수 AMD 최고경영자

GPU의 효과는 극적이었다. 세계적인 AI 석학 앤드류 응Andrew Ng 박사는 CPU를 사용하던 2007년에는 100만개의 신경망 연결을 구동할 수 있었으나, GPU 사용 후

1년 만에 1000만 개의 연결을 구동할 수 있다고 말했다. 이후 인공지능 기술은 엔비디아의 GPU를 중심으로 개발되었다. 그리고 2012년, 알렉스넷AlexNet이라는

인공신경망 기반 AI가 사물 인식 대회에서 압도적인 정확도로 경쟁 알고리즘을 물리치게 된다. 이 사실을 알게 된 구글 등 글로벌 대형 IT 기업들이 AI에 투자를 시작했다. 이로 인해 인공지능의

시대가 열렸고, 핵심 반도체인 GPU의 수요도 늘었다. GPU의 저장소라고 할 수 있는 GDDR 메모리❶ 역시 판매가 늘었다.

챗GPT는 이 흐름에 더욱 강력한 기폭제 역할을 했다. 알렉스넷과 같은 기존 인공지능도 용량이 상당히 컸는데, 챗GPT는 알렉스넷보다 3000배 이상 거대하다. 프로그램의 크기가 3000배나 커지며, 메모리의 부담 또한 커지게 되었다. 요구하는 용량이 기존의 반도체 미세화 기술에 기대서는 감당이 되지 않는 수준. 현존하는 제품 중 가장 성능이 좋고 용량이 높은 HBM의 수요가 폭등하게 된 것이다.

챗GPT는 이 흐름에 더욱 강력한 기폭제 역할을 했다. 알렉스넷과 같은 기존 인공지능도 용량이 상당히 컸는데, 챗GPT는 알렉스넷보다 3000배 이상 거대하다. 프로그램의 크기가 3000배나 커지며, 메모리의 부담 또한 커지게 되었다. 요구하는 용량이 기존의 반도체 미세화 기술에 기대서는 감당이 되지 않는 수준. 현존하는 제품 중 가장 성능이 좋고 용량이 높은 HBM의 수요가 폭등하게 된 것이다.

- ❶ Graphics Double Data Rate 메모리 반도체. 디램의 일종으로 엔비디아가 AI시장을 점령하기 전까지 대세로 주목받았던 고속 메모리 반도체다.

AI를 제대로 구동시키는 유일한 메모리 ‘HBM’

HBM은 현재 AI가 원하는 용량과 성능을 제공할 수 있는 유일한 메모리다. 앞서 살펴보았듯, 연산기는 저장소에서 프로그램의 일부를 가져와 연산하는 방식으로 동작한다. 프로그램의 크기가 커졌다면,

프로그램이 저장된 저장소의 크기도 커져야 할 뿐만 아니라 저장소의 입구도 넓어져야 한다. 용량이 적다면 프로그램 자체가 탑재되지 않을 것이고, 입구가 좁다면 연산기에 프로그램과 데이터 전달이 제대로

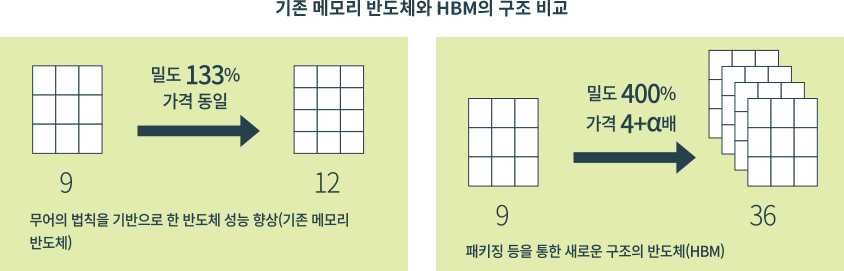

되지 않아 속도가 느려질 것이다. 메모리 회사들은 메모리의 용량과 성능을 높이기 위해, 완성된 단일 메모리 칩을 수직으로 적층하는 방식을 도입했다.

기존 메모리는 가공된 칩 1개가 단일 제품이었다면, HBM은 4~12개를 위로 쌓은 것이 단일 제품이 되는 것이다. 당연히 칩의 용량 또한 4~12배 증가하게 된다. 물론 단순히 칩을 쌓기만 해서 성능까지 좋아지지는 않는다. 적층된 칩에 일종의 데이터 엘리베이터까지 설치하게 된다. 이에 기존에는 메모리 제품 8개를 연결해야 얻을 수 있던 용량과 속도를 하나의 제품으로 얻을 수 있게 된 것이다. 가격 역시 용량과 성능에 비례해 높아졌다.

기존 메모리는 가공된 칩 1개가 단일 제품이었다면, HBM은 4~12개를 위로 쌓은 것이 단일 제품이 되는 것이다. 당연히 칩의 용량 또한 4~12배 증가하게 된다. 물론 단순히 칩을 쌓기만 해서 성능까지 좋아지지는 않는다. 적층된 칩에 일종의 데이터 엘리베이터까지 설치하게 된다. 이에 기존에는 메모리 제품 8개를 연결해야 얻을 수 있던 용량과 속도를 하나의 제품으로 얻을 수 있게 된 것이다. 가격 역시 용량과 성능에 비례해 높아졌다.

AI가 뒤바꾼 산업 지도

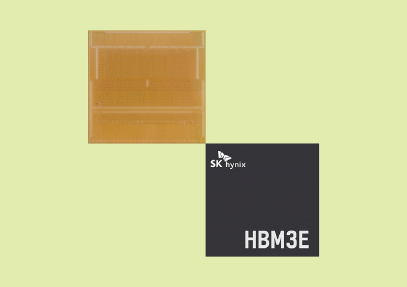

엔비디아에 납품되고 있는 SK하이닉스의 HBM3E 제품.

SK하이닉스는 3월부터 세계 최초로 AI용 메모리 신제품

HBM3E 양산에 성공했다.

인공신경망 기반의 AI 기술이 반도체 시장에 미친 영향은 어마어마하다. 연산 반도체의 주도권을 엔비디아가 인텔로부터 탈환함과 동시에, 기존 회사들이 뚫기 힘든 엔비디아 중심의 AI

소프트웨어 생태계가 생겨났다. 이미 엔비디아 반도체에 맞춘 생태계가 존재하므로, 경쟁사들은 단순 성능만으로는 엔비디아 칩의 점유율을 뺏기 힘들어졌다. 반면 메모리 반도체의 경우, AI의

높은 부가가치 덕분에 기존 원가경쟁에서 벗어나 수익성을 실현할 수 있게 되었다.

제조 가치 사슬의 변화는 예기치 못한 문제와 고민거리 또한 야기한다. 2021년 바이든 행정부는 미국의 반도체 제조 점유율 하락을 우려한 바 있는데, 여기에 GPU 이슈가 있다. GPU는 대만 TSMC에서 위탁생산하기 때문이다. 따라서 CPU 수요를 GPU가 차지하면, 대만의 반도체 점유율이 더욱 높아지게 된다.

제조 가치 사슬의 변화는 예기치 못한 문제와 고민거리 또한 야기한다. 2021년 바이든 행정부는 미국의 반도체 제조 점유율 하락을 우려한 바 있는데, 여기에 GPU 이슈가 있다. GPU는 대만 TSMC에서 위탁생산하기 때문이다. 따라서 CPU 수요를 GPU가 차지하면, 대만의 반도체 점유율이 더욱 높아지게 된다.

후공정의 중요성 또한 커지고 있다. AI를 구동하기 위해선 최대한 많은 연산 회로를 쌓아야 할 뿐만 아니라, 고속-고용량의 메모리를 GPU에 매우 가깝게 배치해야 한다. HBM을 만드는

기술, GPU에 HBM을 연결하는 과정 등은 모두 후공정에 해당한다. 지금까지 연산기와 저장소를 잘 만드는 게 중요했다면 이젠 그 둘 사이의 도로까지 신경 써야 하게 된 것이다.

우리는 하나의 신기술이 전 세계 산업과 안보에 얼마나 큰 파장을 일으킬 수 있는지 알고 있다. 특히 IT 분야는 미국, 중국 등 기술 선진국이 국가의 명운을 걸고 투자하는 산업이다. 따라서 ‘인공지능AI = GPU+HBM’이라는 단순 암기식을 외우고 넘어간다면, 이후에 나타날 제2의 AI 혁명을 놓치게 될지도 모른다. AI 이론의 등장과 혁명의 과정에서 활약한 수많은 반도체 회사들을 잘 지켜봐야 한다. 새로운 기술혁신이 일어날 때 그 의의를 빠르게 파악하고 어떻게 파트너가 될 수 있는지 고민해야 한다.

우리는 하나의 신기술이 전 세계 산업과 안보에 얼마나 큰 파장을 일으킬 수 있는지 알고 있다. 특히 IT 분야는 미국, 중국 등 기술 선진국이 국가의 명운을 걸고 투자하는 산업이다. 따라서 ‘인공지능AI = GPU+HBM’이라는 단순 암기식을 외우고 넘어간다면, 이후에 나타날 제2의 AI 혁명을 놓치게 될지도 모른다. AI 이론의 등장과 혁명의 과정에서 활약한 수많은 반도체 회사들을 잘 지켜봐야 한다. 새로운 기술혁신이 일어날 때 그 의의를 빠르게 파악하고 어떻게 파트너가 될 수 있는지 고민해야 한다.

AI 칩 수요 폭증 이후 HBM 공급 부족 현상을 겪고 있다.

사진은 서울에서 열린 KOREA INVESTMENT WEEK 2023에서 AI 트렌드와 HBM 전망에 대해 발표하고 있는 박명수 SK하이닉스 DRAM 마케팅 부사장

사진은 서울에서 열린 KOREA INVESTMENT WEEK 2023에서 AI 트렌드와 HBM 전망에 대해 발표하고 있는 박명수 SK하이닉스 DRAM 마케팅 부사장

정인성 IT 작가

반도체 회사에서 소프트웨어를 개발하다, 이후 백엔드 개발자가 되었다. <반도체 제국의 미래>를 집필하며 작가를 겸하게 되었고, 이후 를 집필하였다. 현재 칼럼을 기고하며,

반도체 분야 강연을 하고 있다.

이번 호 PDF 다운로드

이번 호 PDF 다운로드